POC监控历程 2025-08 更新

记录一下写的关于 POC 监控的相关工具。到现在写了 3 个版本了,后续大概就是在第三个版本基础上去做。

因为工作需要去找网上的 POC 然后写插件,所以学校事情完成后就开始着手开发。

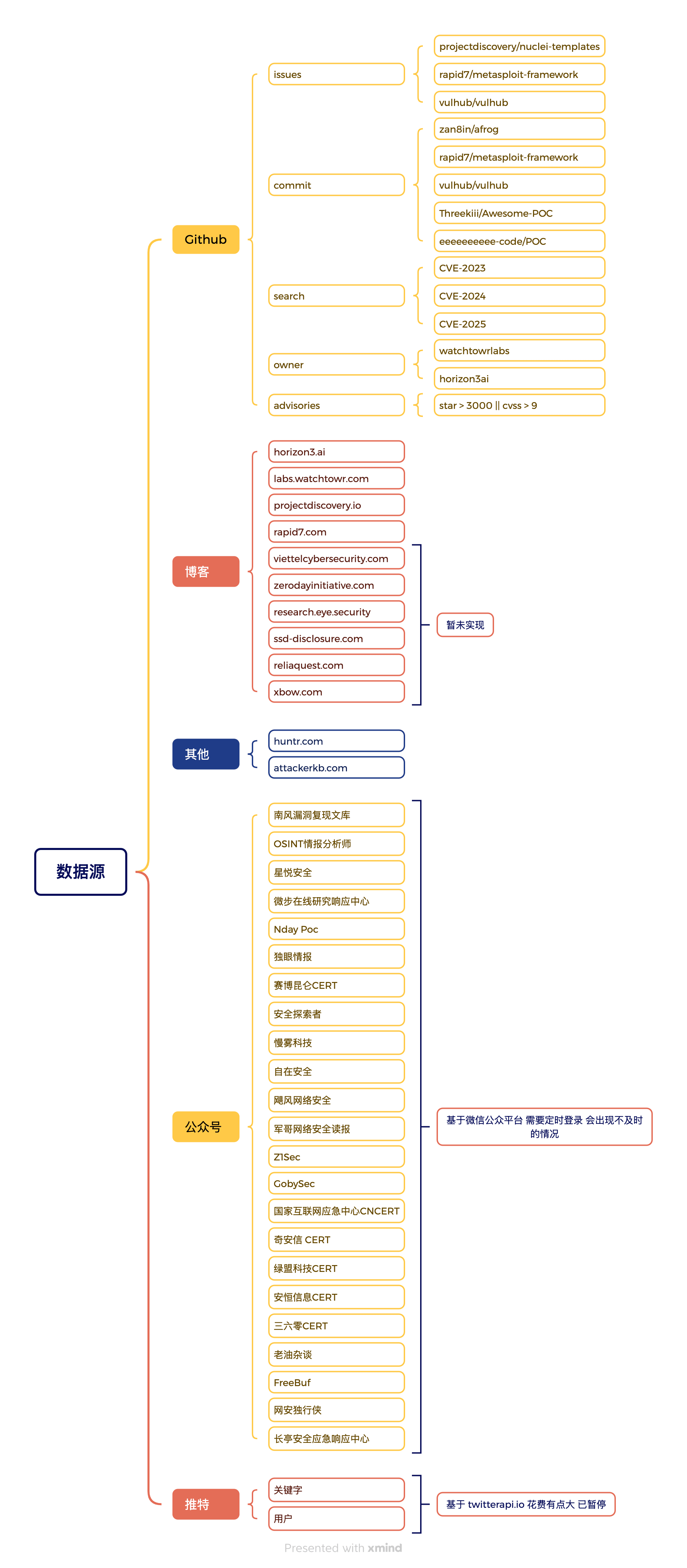

当时 Github 上的确有相关 CVE POC 监控的项目,但都是 Github 搜索关键词,对于 nuclei、msf、wy876 这种基于 pr 和 commit 更新好像是没有发现的,所以只能自己写了。

2024-08

Golang 开发,简单的爬虫配合 cel 表达式实现信息过滤,数据源比较全,还有 NVD 漏洞。

直接用 Go 做的定时任务,可以在配置文件中修改。

2024-11

逻辑还是之前的逻辑,但是使用 Go Gin + Mysql + Vue 实现的开发,前后端分离。

前端是基于 pure-admin-thin 后台项目管理系统为基础进行开发的,整体也算体验了一次 Golang 的 WEB 开发。

也算是实操了一下 WEB 项目的架构,之前只是单独的 Gin 知识。

整体来讲就是这样:

因为搭建原因弃用。

之前服务器重置过一次,然后重新部署的时候发现有点太麻烦了,因为原本的任务和相关的过滤表达式都没有备份,重新添加太过麻烦了。所以在第三版之前使用的都是第一个版本。

2025-05

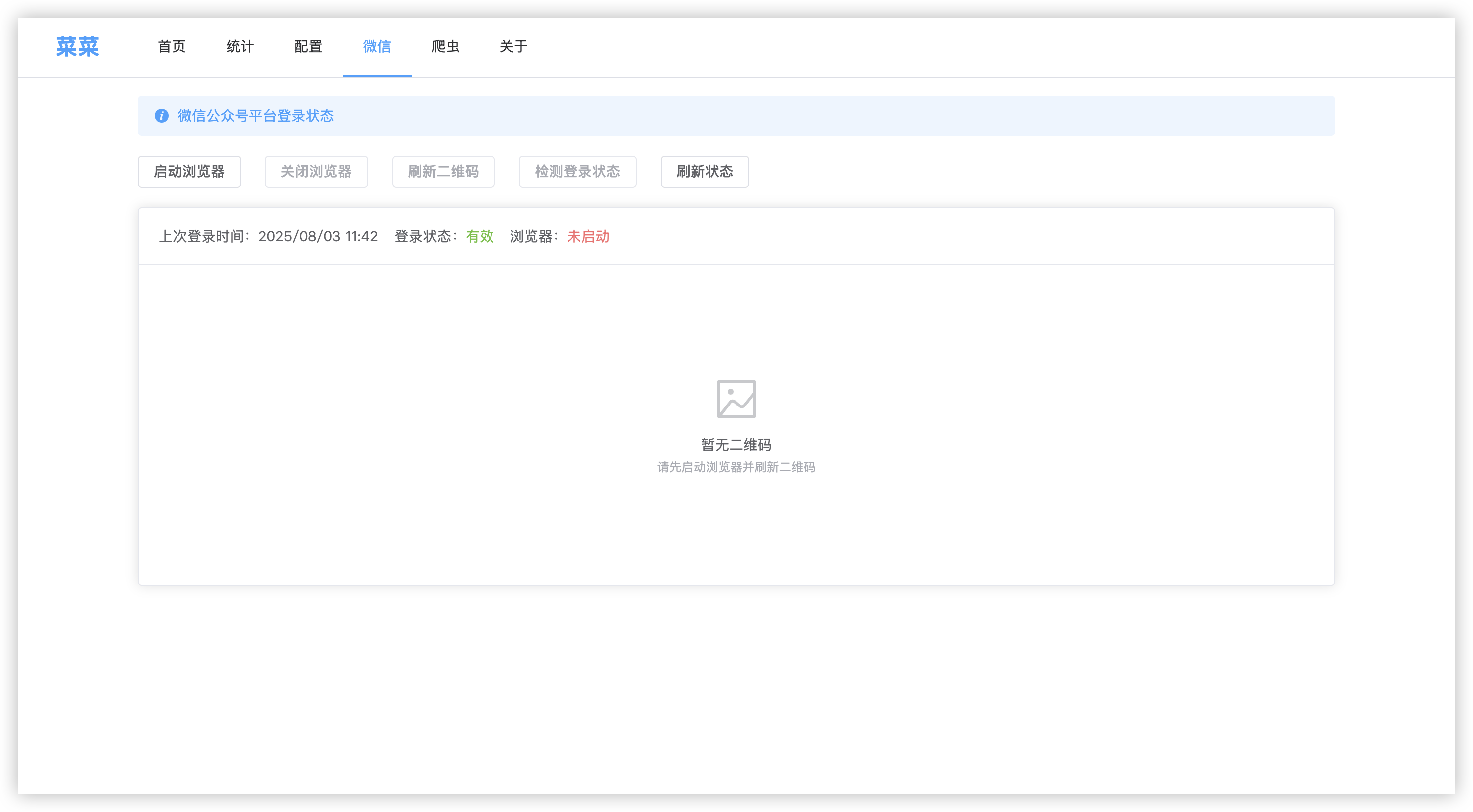

因为发现其实一些博客、微信公众号是很多 POC 的来源,但是在第一个版本中其实并不太好添加,要在原本数据源监测模块添加逻辑,然后重新编译,没有办法打到简单方便的目的。

所以这版本就直接用 Python 来写了,Python 爬虫 + Linux 的 Crontab 计划任务,想添加数据源加个脚本,加个计划任务就可以了。

而且 Python 写这种爬虫比 Go 要好写多了,目前是把数据推送到钉钉还有另外一个 Github 的博客上面,也存储有原始的 JSON 数据,方便后续写个 WEB 去更好的展示。

并且还配合了 AI 替代了之前通过 cel 表达式来过滤无用信息的办法。

DeepSeek 真的蛮划算的,一个月不到 10 块钱,hhhh

2025-07

对 POC 监控没有什么改版,又单独写了一个 AI POC 转换的模块,和监测是分开的,监测到的可以用 AI 转换的 POC 就存储为指定格式,然后定时同步到 AI 转换扫描的机器上面去扫,目前看来是有效果的,只是和人是比不了的。

后续就准备开始 WEB 的开发了

2025-08

最近 3 个周末时间基本都耗费这个上了….

做了哪些更新?

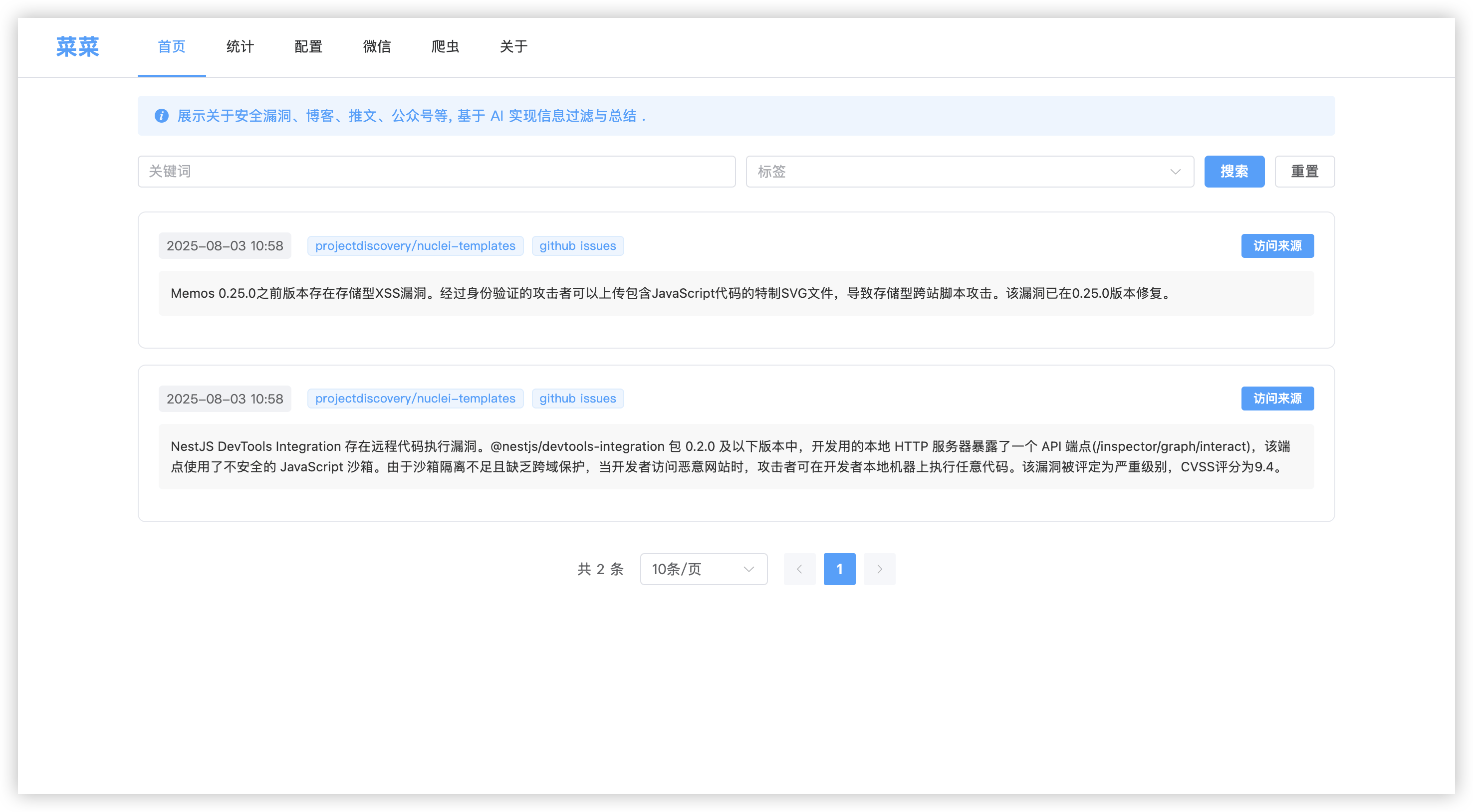

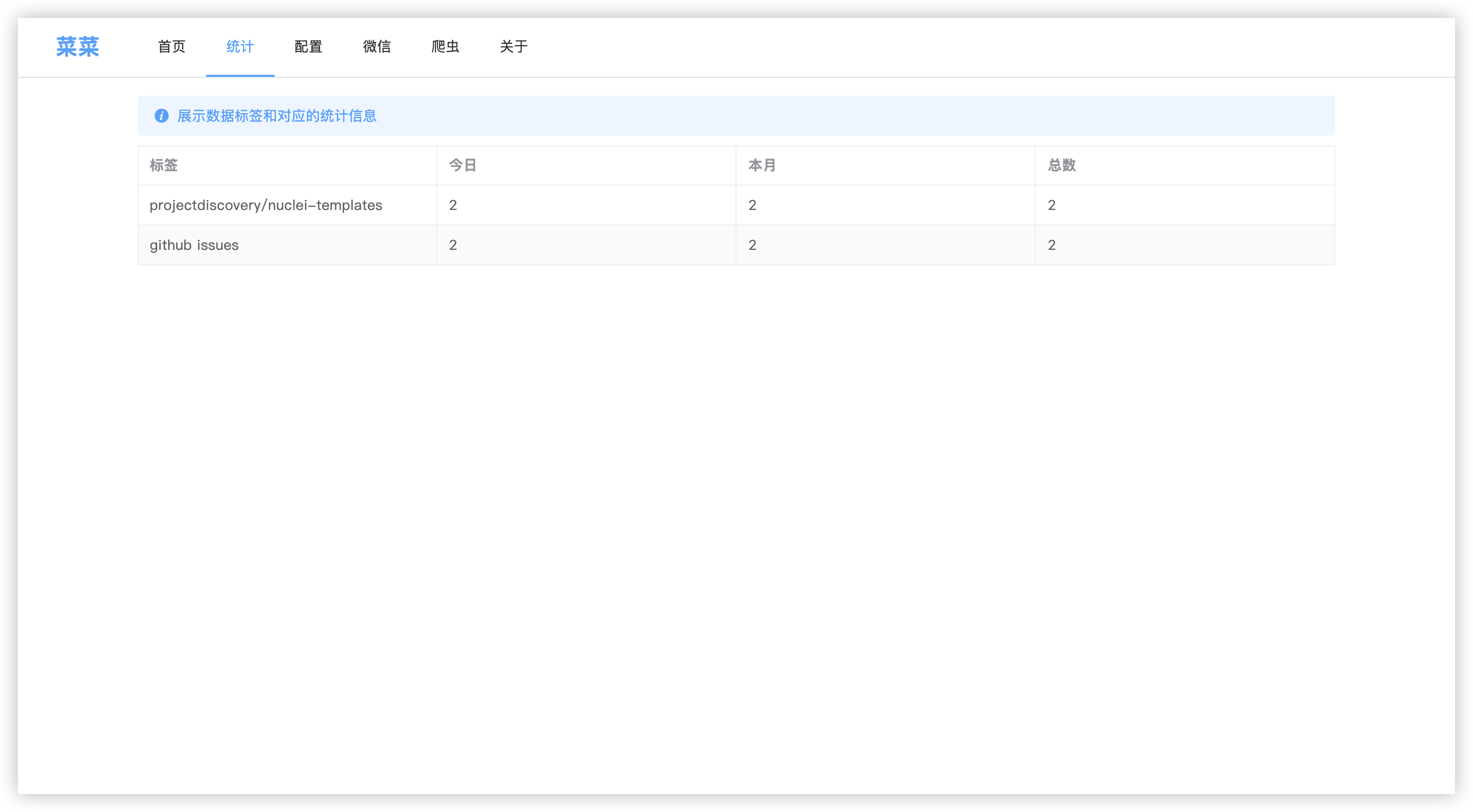

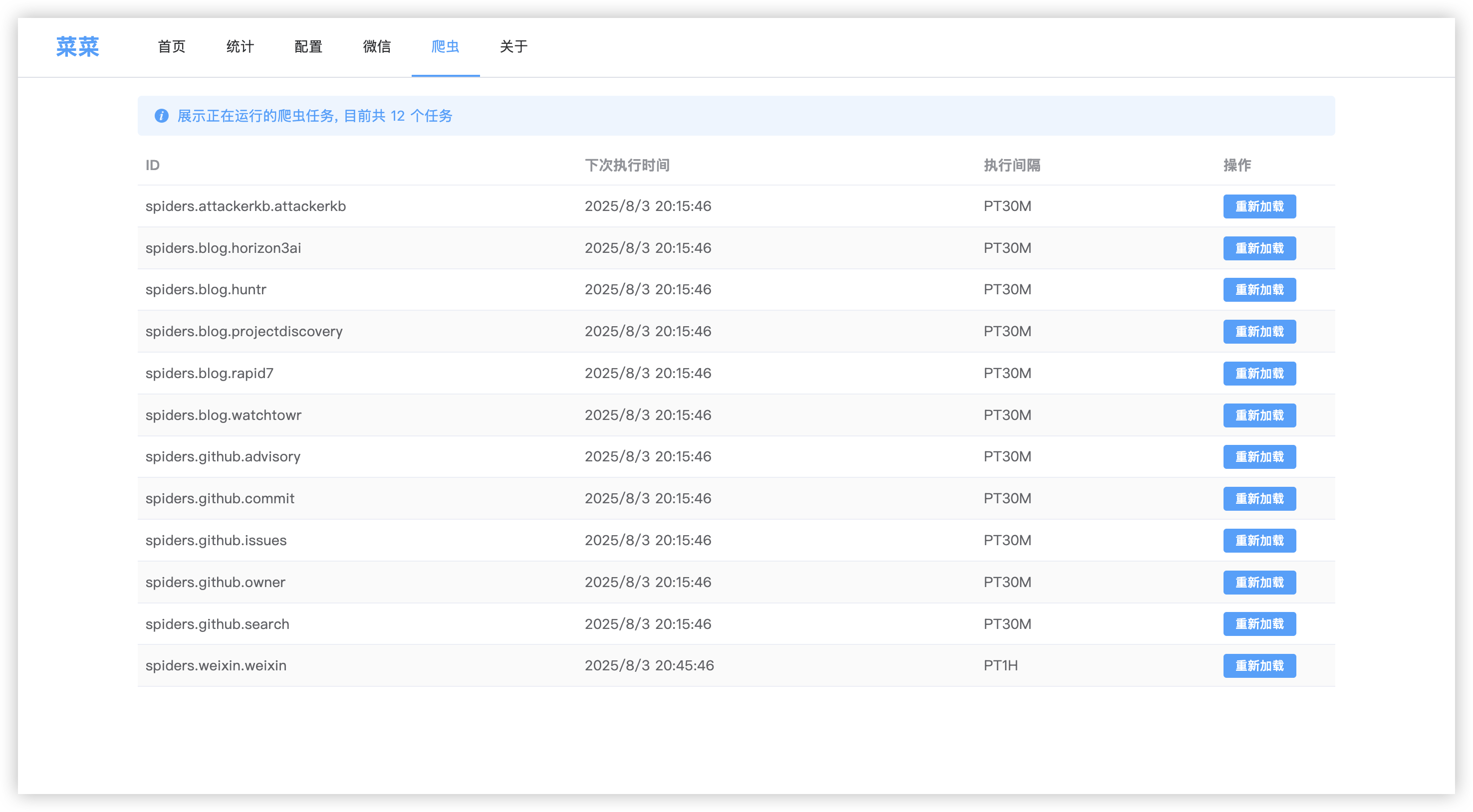

- web 开发 fastapi + vite + element-ui

- 体系变更 不在做 POC 的漏洞格式化,而是借助 ai 把 poc、博客、公众号、推特都做总结让人可以直接看到讲的什么

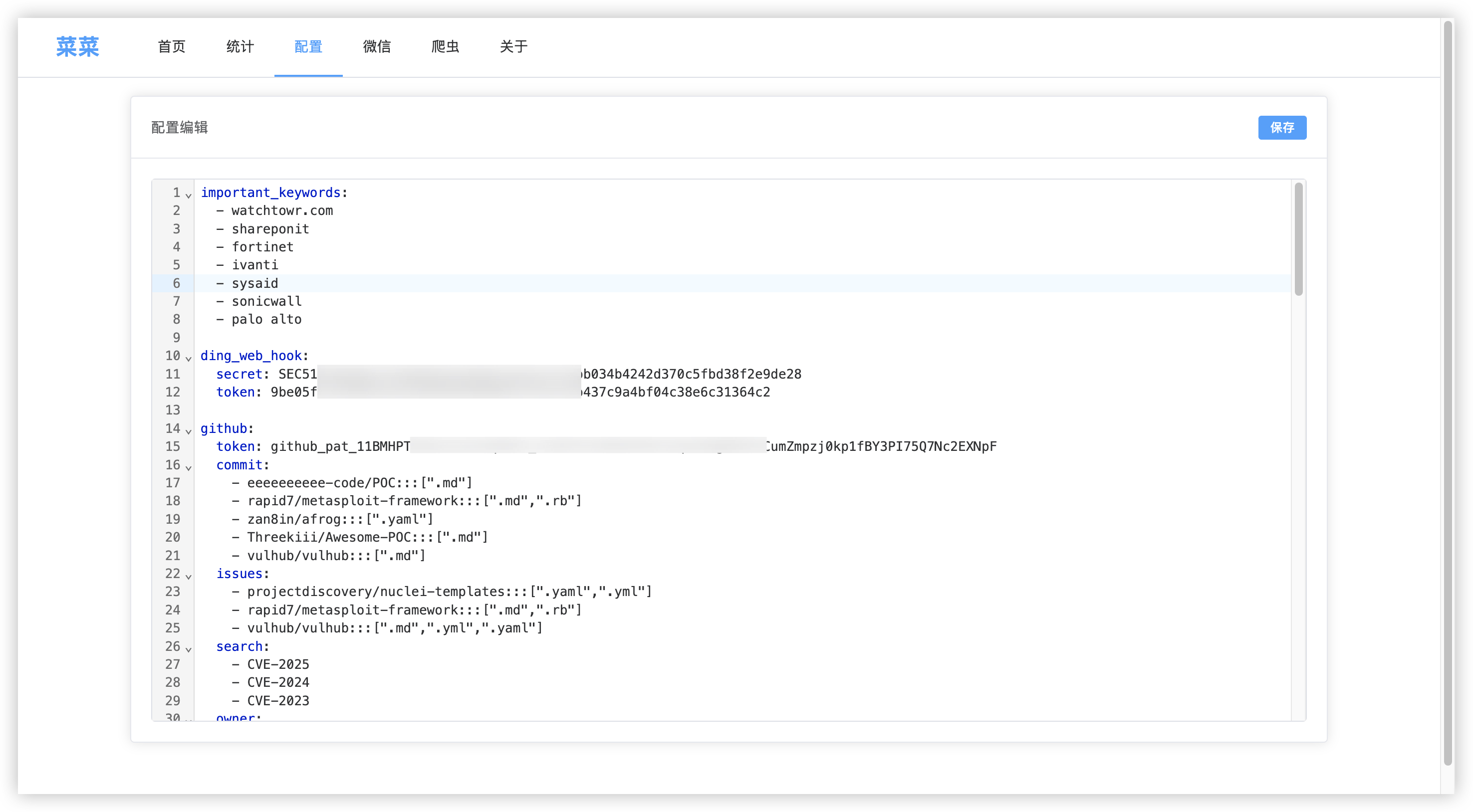

- 去掉 crontab 的依赖,使用动态加载的功能,定时扫描指定位置然后注册爬虫和对应的时间间隔

- 爬虫封装,无需手动编写 ai 逻辑,博客类只需要把标题和链接获取到其他就不需要管

- 重点监测:之前的逻辑是把信息都发到钉钉 可以看不过来 那么就只通知我重要的即可

重点关键字

针对描述或者标签中包含下面的就打一个 “重要” 的标签,并且做出消息通知。

- watchtowr.com

- shareponit

- fortinet

- ivanti

- sysaid

- sonicwall

- palo alto